Apple quét iPhone, iCloud tìm ảnh lạm dụng trẻ em

Cập nhật: 06/08/2021

![]() Phó Thủ tướng Nguyễn Chí Dũng: Tạo nền tảng quan trọng cho công nghiệp bán dẫn

Phó Thủ tướng Nguyễn Chí Dũng: Tạo nền tảng quan trọng cho công nghiệp bán dẫn

![]() Công nghệ pin giúp xe điện có thể chạy 1.500 km sau một lần sạc

Công nghệ pin giúp xe điện có thể chạy 1.500 km sau một lần sạc

Tính năng mới của Apple sẽ ra mắt cuối năm nay, song đang vấp phải sự phản đối từ các chuyên gia bảo mật và quyền riêng tư.

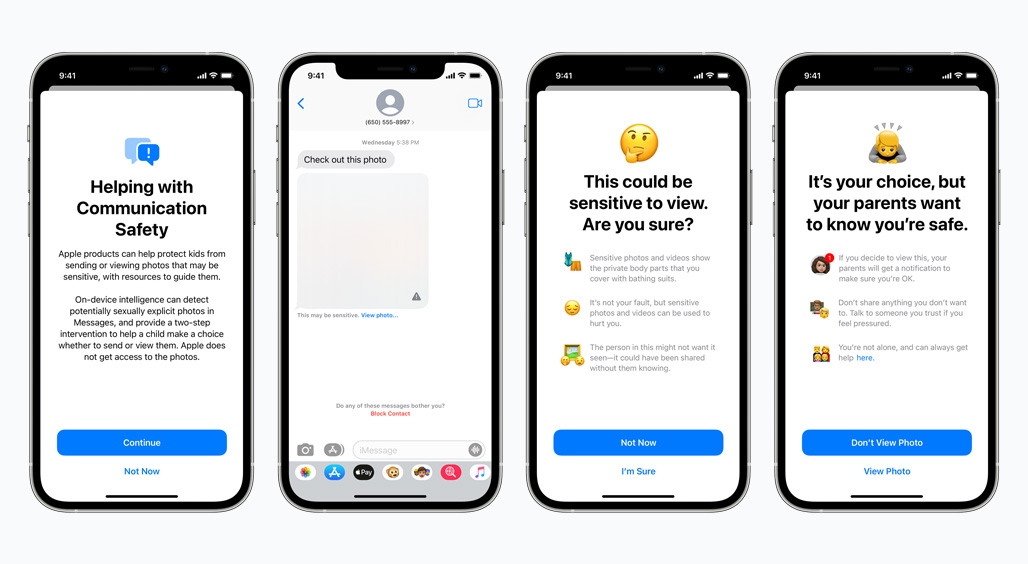

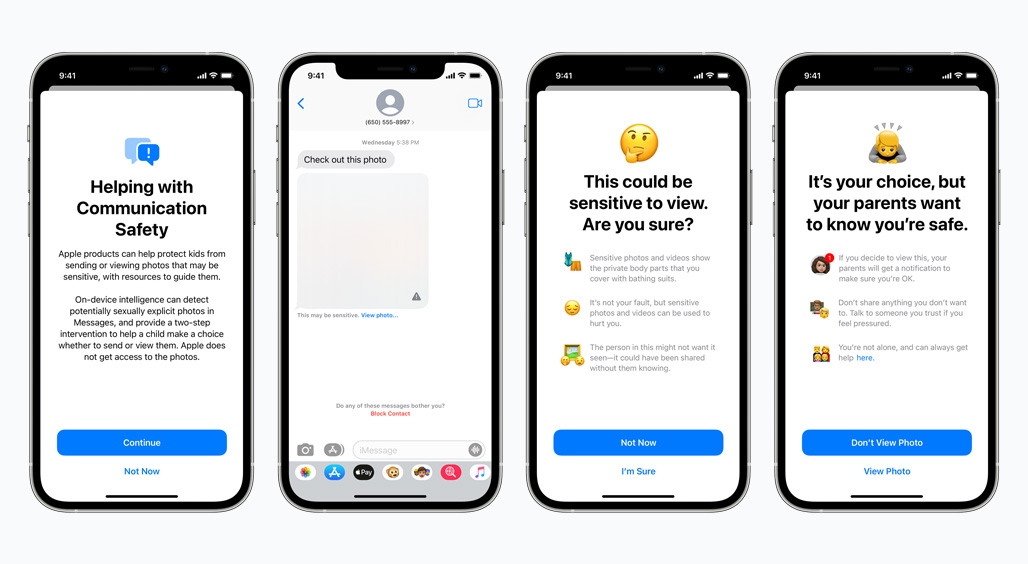

Cuối năm nay, Apple sẽ ra mắt công nghệ cho phép công ty phát hiện và báo cáo nội dung lạm dụng tình dục trẻ em (CSAM) cho nhà hành pháp. Trả lời TechCrunch, “táo khuyết” cho biết đây là một trong vài tính năng mới nhằm bảo vệ trẻ em tốt hơn trước các nguy cơ trực tuyến, bao gồm bộ lọc chặn hình ảnh khiêu dâm gửi và nhận qua tài khoản iMessage của trẻ. Một tính năng khác sẽ can thiệp khi người dùng cố tìm kiếm các từ khóa liên quan tới CSAM trên Siri và Search.

Theo Apple, công nghệ phát hiện CSAM mới – NeuralHash – sẽ hoạt động trên thiết bị người dùng và có thể phát hiện khi người dùng tải ảnh lạm dụng trẻ em lên iCloud mà không cần giải mã hình ảnh.

Tin tức về nỗ lực mới của Apple bị lộ ra sau khi Matthew Green, một giảng viên Mật mã học tại Đại học John Hopkins, đăng lên Twitter. Không chỉ vấp phải phản ứng từ một số nhà hoạt động quyền riêng tư và chuyên gia bảo mật, Apple còn bị người dùng phản đối.

Apple đang cố xoa dịu cơn tức giận từ mọi người bằng cách nhấn mạnh tới nhiều lớp mã hóa để đảm bảo quyền riêng tư. NeuralHash sẽ có mặt trên iOS 15 và macOS Monterey trong 1 hoặc 2 tháng tới. Nó hoạt động bằng cách chuyển đổi hình ảnh trên iPhone hoặc Mac thành một chuỗi ký tự và số độc nhất vô nhị (hash). Bất cứ khi nào thay đổi hình ảnh, hash cũng thay đổi. NeuralHash muốn bảo đảm hình ảnh gốc và hình ảnh tương tự - chẳng hạn đã cắt cúp và qua chỉnh sửa – đều có chung hash.

Trước khi ảnh được tải lên iCloud Photos, các hash trên thiết bị sẽ được đối chiếu với một cơ sở dữ liệu các hash về ảnh lạm dụng trẻ em do các tổ chức bảo vệ trẻ em cung cấp. NeuralHash sử dụng kỹ thuật mật mã có tên private set intersection để phát hiện các hash khớp mà không tiết lộ hình ảnh là gì hay cảnh báo người dùng.

Apple có thể giải mã hình ảnh, xác minh thủ công nội dung, vô hiệu hóa tài khoản người dùng và báo cáo hình ảnh cho nhà chức trách. Theo công ty, tỉ lệ sai sót là 1/1.000 tỷ nhưng sẽ có quy trình kháng nghị.

Dù vậy, nhiều người cảm thấy không thoải mái khi trao dữ liệu cho một thuật toán. Vài chuyên gia bảo mật kêu gọi cần thảo luận trước công chúng trước khi Apple triển khai công nghệ này./.

![]() Từ khóa: Apple, iCloud Photos, trẻ em, tính năng mới, lạm dụng trẻ em

Từ khóa: Apple, iCloud Photos, trẻ em, tính năng mới, lạm dụng trẻ em

![]() Thể loại: Khoa học - Công nghệ

Thể loại: Khoa học - Công nghệ

![]() Tác giả:

Tác giả:

![]() Nguồn tin: VOVVN

Nguồn tin: VOVVN