Chiêu trò cắt ghép ảnh deepfake để tống tiền, lừa đảo trực tuyến đang gia tăng

Cập nhật: 3 giờ trước

![]() Huế, Bộ Xây dựng hỗ trợ bà con miền Bắc khắc phục bão lũ

Huế, Bộ Xây dựng hỗ trợ bà con miền Bắc khắc phục bão lũ

![]() Bão số 12 hướng vào đất liền, gây biển động mạnh ở khu vực Hoàng Sa

Bão số 12 hướng vào đất liền, gây biển động mạnh ở khu vực Hoàng Sa

VOV.VN - Hiện nay, với sự phát triển của trí tuệ nhân tạo, công nghệ deepfake đang trở thành công cụ nguy hiểm cho tội phạm tống tiền, lừa đảo trực tuyến. Thông qua nền tảng mạng xã hội, các đối tượng xấu dễ dàng lợi dụng để thực hiện hành vi vi phạm pháp luật.

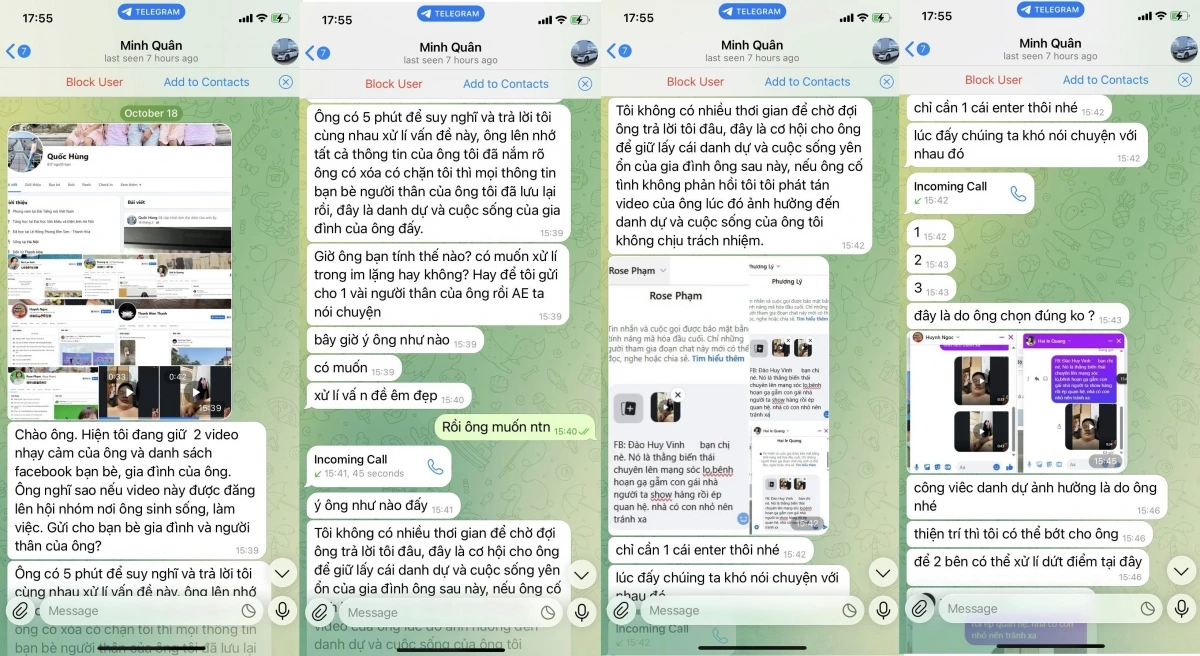

Gần đây, trên mạng xã hội xuất hiện thêm hình thức lừa đảo mới. Đó là ghép mặt người vào những hình ảnh/clip nóng để tống tiền. Cụ thể, anh N.H.V (Hà Nội) chia sẻ, ngày 18/10 vừa qua, có một tài khoản telegram gọi video call cho mình. Tài khoản này giống hệt tên một người bạn của mình nên anh không hề nghi ngờ gì.

Khi bật video lên thì phía bên kia toàn hình ảnh giống như một người đang đi ngoài đường, không rõ mặt và rất ồn. Người này liên tục hỏi “mặt ông đâu sao không thấy” và sau khi mình chuyển sang camera đằng trước để nói chuyện thì vài giây sau cuộc gọi kết thúc.

“Nghĩ rằng bạn mình đang đi ngoài đường, tín hiệu không ổn định nên tôi cũng không quan tâm và chờ bạn gọi lại. Nhưng khoảng 30 phút sau đó, khi mà “ông bạn vàng” ấy vẫn chưa gọi lại thì có một tài khoản khác nhắn tin cho tôi. Trong tin nhắn gồm 2 video clip, hình ảnh là từ cuộc video call lúc trước, nhưng đã bị đối tượng dùng deepfake chỉnh sửa thành mình đang có hành động nhạy cảm”, anh N.H.V cho biết.

Đối tượng này yêu cầu anh N.H.V phải chuyển 20 triệu nếu không muốn 2 clip này bị gửi tới tất cả bạn bè của mình. Sau khi trao đổi khoảng 5 phút, khoảng thời gian đủ để người bị lừa đảo hiểu câu chuyện - có một số máy lạ gọi tới. Đối tượng này liên tục đưa ra những lời dọa nạt và yêu cầu phải chuyển tiền ngay. Khi anh N.H.V bảo không có tiền, đối tượng giảm xuống còn 10 triệu đồng vì lý do “thấy tôi khá thiện chí”.

“Khi tôi vẫn bảo mình không có tiền thì đối tượng bảo phải đi vay “vì làm truyền hình thì sao không vay nổi 10 triệu”. Sau đó liên tục các số điện thoại lạ gọi tới nhưng tôi không nghe máy và cũng không trả lời thêm bất kỳ tin nhắn nào của những đối tượng này.

Chiều 20/10, tôi đã ra công an phường Đông Ngạc trình báo về vụ việc. Các đồng chí công an cho biết là thủ đoạn này đang có chiều hướng tăng cao từ khoảng 2 tháng trở lại đây. Tuy nhiên, do tôi chưa bị mất tiền nên lực lượng chức năng không tiếp nhận vụ việc của mình do không có yếu tố hình sự”, anh N.H.V cho hay.

Theo anh N.H.V, đây là một thủ đoạn cực kỳ mới và thủ đoạn cực kỳ trắng trợn. Vì vậy anh đã chia sẻ lên mạng xã hội để người quen, bạn bè và mọi người cùng biết và hết sức cảnh giác khi nhận cuộc gọi video.

Từ đầu năm 2025, Cục An ninh mạng và phòng, chống tội phạm sử dụng công nghệ cao (A05, Bộ Công an) đã ghi nhận hàng trăm vụ lừa đảo sử dụng công nghệ deepfake tại Việt Nam, chiếm đoạt hàng chục tỷ đồng. Đặc biệt, phần lớn nạn nhân là người lớn tuổi, phụ huynh có con đi xa, hoặc doanh nhân thường xuyên giao dịch trực tuyến.

Theo các chuyên gia, các nhóm lừa đảo thường thu thập thông tin từ mạng xã hội, nơi nhiều người công khai hình ảnh, giọng nói, lịch học, thậm chí cả địa điểm đang ở. Từ đó, chúng dựng video giả mạo và gọi điện video qua các ứng dụng phổ biến như Zalo, Messenger, Telegram. Một kịch bản quen thuộc là “giả người thân bị tai nạn”, “giả sếp yêu cầu chuyển tiền gấp”, hoặc “giả nhân viên ngân hàng hỗ trợ tài khoản”…

Một chuyên gia của Cục An ninh mạng (A05, Bộ Công an) cho biết: “Chúng tôi từng ghi nhận trường hợp kẻ gian chỉ dùng 20 giây âm thanh từ video TikTok để huấn luyện trí tuệ nhân tạo tạo giọng nói giả, đủ để gọi điện thuyết phục người nhà chuyển tiền”. Điều đáng nói, công nghệ deepfake hiện đã được thương mại hóa rộng rãi, thậm chí có thể thuê gói “deepfake call” trên các nền tảng ngầm với giá chỉ vài trăm nghìn đồng.

Về pháp lý, Việt Nam hiện đã có Luật An ninh mạng (2018) và Nghị định 53/2022, quy định rõ việc giả mạo, xuyên tạc, phát tán thông tin sai sự thật đều có thể bị xử lý hình sự. Tuy nhiên, việc nhận dạng deepfake vẫn là thách thức vì công nghệ ngày càng tinh vi, khó phân biệt bằng mắt thường.

Tổ chức Interpol cảnh báo rằng đến năm 2026, các vụ lừa đảo sử dụng deepfake có thể gây thiệt hại hơn 25 tỷ USD toàn cầu.

Theo cơ quan công an, việc sử dụng deepfake để lừa đảo và tống tiền là vô cùng nghiêm trọng. Nạn nhân không chỉ mất tiền mà còn có thể bị tổn hại về danh dự, uy tín. Các vụ việc này còn tạo ra sự hoang mang trong cộng đồng, làm mất lòng tin vào các nội dung trên mạng xã hội và các phương tiện truyền thông.

Trước tình trạng này, Công an nhiều địa phương trên cả nước đã đưa ra lời cảnh báo. Cụ thể, Công an TP.HCM cũng khuyến cáo người dân khi gặp các trường hợp tương tự phải nâng cao tinh thần cảnh giác với phương châm “Không hoảng sợ - Không làm theo yêu cầu chuyển tiền của đối tượng”; đồng thời, phải liên hệ ngay với cơ quan Công an nơi gần nhất để cung cấp thông tin, phối hợp nhanh chóng điều tra, xử lý. Công an TP Cần Thơ cũng khuyến nghị người dân không chia sẻ thông tin cá nhân lên mạng xã hội ở chế độ công khai, không truy cập vào các đường dẫn lạ (được gửi kèm trong tin nhắn hoặc email); luôn cẩn trọng khi tiếp nhận các cuộc gọi, tin nhắn từ những nguồn không quen biết, không rõ ràng.

Theo chuyên gia an ninh mạng Ngô Minh Hiếu (Hiếu PC), trong kỷ nguyên số, công nghệ deepfake đang nổi lên như một mối đe dọa mới với nhiều ứng dụng tiềm ẩn nguy hiểm, trong đó có lừa đảo và tống tiền. Deepfake là công nghệ sử dụng trí tuệ nhân tạo để tạo ra các video, hình ảnh hoặc âm thanh giả mạo nhưng trông rất chân thực. Khả năng tái tạo giọng nói, khuôn mặt và hành động của người khác đã mở ra cánh cửa cho nhiều hành vi phi pháp, bao gồm cả việc sử dụng deepfake để lừa đảo và tống tiền.

Chuyên gia an ninh mạng khuyến nghị 5 bước cơ bản giúp người dân tự bảo vệ trước nguy cơ deepfake.

Thứ nhất, không chuyển tiền qua video call nếu chưa xác minh bằng kênh khác (gọi lại số cũ, hỏi qua người quen).

Thứ hai, hạn chế đăng tải hình ảnh và video cá nhân công khai - càng ít dữ liệu, trí tuệ nhân tạo càng khó học.

Thứ ba, kiểm tra dấu hiệu bất thường: video có thể hơi giật, ánh sáng da không tự nhiên, miệng nói lệch nhẹ so với âm thanh.

Thứ tư, sử dụng phần mềm xác thực khuôn mặt thật (liveness detection) nếu làm việc trong môi trường yêu cầu nhận diện người dùng.

Thứ năm, báo ngay cơ quan chức năng nếu nghi ngờ bị giả mạo, để kịp thời ngăn chặn việc lan truyền hoặc lừa đảo tiếp theo.

Deepfake đặt ra câu hỏi lớn cho xã hội hiện đại, khi hình ảnh, giọng nói và cảm xúc đều có thể bị sao chép, điều gì còn thật? Câu trả lời không chỉ nằm ở công nghệ, mà ở thái độ cảnh giác của mỗi người. Tin tưởng nhưng phải kiểm chứng, chia sẻ nhưng phải biết giới hạn – đó là kỹ năng sống còn trong thời đại trí tuệ nhân tạo. Và chỉ khi mỗi cá nhân đủ tỉnh táo, chúng ta mới không trở thành nạn nhân trong thế giới ảo đầy cạm bẫy này.

![]() Từ khóa: lừa đảo trực tuyến, lừa đảo trực tuyến, deepfake, công nghệ deepfake, tống tiền lừa đảo trực tuyến, tội phạm tống tiền clip nóng, clip nóng sử dụng deepfake

Từ khóa: lừa đảo trực tuyến, lừa đảo trực tuyến, deepfake, công nghệ deepfake, tống tiền lừa đảo trực tuyến, tội phạm tống tiền clip nóng, clip nóng sử dụng deepfake

![]() Thể loại: Xã hội

Thể loại: Xã hội

![]() Tác giả: vân anh/vov.vn

Tác giả: vân anh/vov.vn

![]() Nguồn tin: VOVVN

Nguồn tin: VOVVN